La regulación sobre la inteligencia artificial es un tema que se ha popularizado luego de ver todos los posibles riesgos que presenta esta creciente tecnología. De hecho, la Unión Europea (UE) ha propuesto una ley de inteligencia artificial que busca establecer un marco normativo armonizado y basado en principios éticos para garantizar una IA segura, transparente y responsable.

La ley de inteligencia artificial clasifica los sistemas de IA según el nivel de riesgo que implican para los usuarios y la sociedad, y establece diferentes obligaciones para los proveedores y usuarios de estos sistemas.

- Los sistemas de IA de riesgo inaceptable, como los que manipulan el comportamiento humano o violan la privacidad, serán prohibidos.

- Los sistemas de IA de alto riesgo, como los que se usan en la salud, el transporte o la justicia, estarán sujetos a requisitos estrictos de calidad, seguridad y supervisión humana.

- Los sistemas de IA de riesgo limitado, como los chatbots o los filtros de contenido, deberán informar a los usuarios de que están interactuando con una máquina.

- Los sistemas de IA de riesgo mínimo, como los que se usan con fines recreativos o artísticos, estarán exentos de obligaciones específicas.

La ley de inteligencia artificial pretende fomentar la innovación y la competitividad en el ámbito de la IA, al tiempo que protege los valores y los derechos fundamentales de la UE. La ley también prevé la creación de un comité europeo de inteligencia artificial que asesorará y apoyará a la Comisión y a los Estados miembros en la aplicación y actualización del marco normativo.

El debate que ha traído la regulación sobre la inteligencia artificial

En BBVA, Juan Murillo, miembro del equipo de Estrategia de Datos en BBVA, y Jesús Lozano, miembro del equipo de Regulación Digital en BBVA, crearon un debate para conocer esos aspectos que deben tomarse en cuenta para regular la inteligencia artificial.

En este destacan como por eras la humanidad se ha enfrentado a cambios beneficiosos, pero estos acompañados por riesgos. Parece que la IA es un tema reciente, pero recuerdan que es un tema con más de 70 años que ha pasado por muchas fases y que sigue evolucionando.

Sin embargo, se dejó en el foco durante el 2017 con los reguladores en el que el “Parlamento Europeo recomendó a la Comisión Europea el desarrollo de leyes civiles sobre robótica” con el objetivo de establecer un marco jurídico común para regular la ética, la responsabilidad y la seguridad de los robots y los sistemas de inteligencia artificial. El Parlamento Europeo consideró que la robótica plantea desafíos sociales, económicos y jurídicos que requieren una respuesta coordinada a nivel europeo.

No obstante, las respuestas a esta petición las comenzaron a mencionar durante el 2020. Entonces, los autores de BBVA mencionan que la regulación sobre la inteligencia artificial implica tres dilemas:

Una regulación muy vinculada a la tecnología podría quedar obsoleta rápidamente, ya que la tecnología evoluciona a gran velocidad.

Una regulación muy vinculada a la tecnología puede penalizar el avance técnico: podría llegar a favorecer los sistemas poco sofisticados frente a los más avanzados.

Regular una tecnología concreta requiere determinar claramente el objeto de la regulación, es decir, es necesario definir y acotar perfectamente el ámbito de la regulación para no dar lugar a interpretaciones posteriores dispares.

Concluyen que para mitigar riesgos, la atención primordial de la regulación sobre la inteligencia artificial debe estar dirigida a las aplicaciones y sus efectos, no en los métodos.

“No sería ético que la implementación de la IA creara nuevos riesgos, pero tampoco lo sería privar a la sociedad de las oportunidades que puede aportar”.

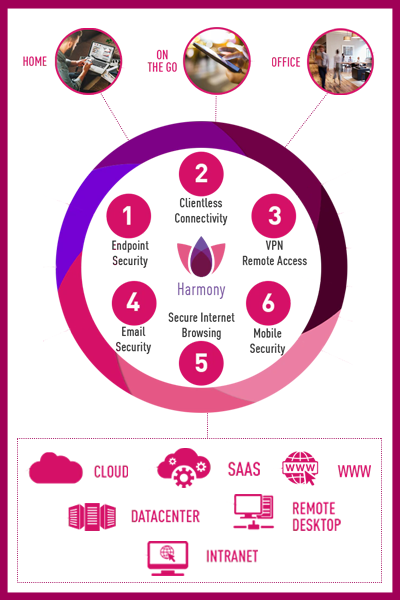

Normas para el uso correcto de la IA en la ciberseguridad

Hasta ahora, el discurso más repetido en cuánto a la regulación sobre la inteligencia artificial es:

– La IA debe estar dirigida y controlada por humanos, que deben supervisar su funcionamiento y asumir la responsabilidad de sus resultados.

– La IA debe incorporar principios de privacidad desde el diseño y garantizar la protección de los datos personales y sensibles que procesa.

– La IA debe mantener un nivel alto de excelencia científica y técnica, basándose en los mejores estándares y prácticas disponibles.

– La IA debe ser transparente y explicar sus métodos, objetivos y resultados a los usuarios y las autoridades competentes.

– La IA debe ser segura y fiable, evitando errores, sesgos o vulnerabilidades que puedan comprometer su integridad o eficacia.

– La IA debe ser ética y respetuosa con los valores democráticos, los derechos fundamentales y la diversidad humana.

El uso correcto de la IA en la ciberseguridad puede aportar muchos beneficios para la sociedad, como una mayor protección frente a las ciberamenazas, una mayor eficiencia en la gestión de la seguridad y una mayor innovación en el sector.

No obstante, también es necesario tener en cuenta los posibles riesgos y desafíos que implica esta tecnología y adoptar unas normas que garanticen su uso responsable y ético. ¡Síganos en redes sociales y conozca más de la regulación sobre la inteligencia artificial!

Facebook: Eagle Tech Corp

Instagram: @eagletech_corp

Twitter: @eagletechcorp

LinkedIn: Eagle Tech

YouTube: Eagle Tech Corp